一、Docker概述

1、Docker是什么

Docker 是一个开源的应用容器引擎 ,基于 Go 语言 并遵从 Apache2.0 协议开源;

Docker 可以让开发者打包他们的应用以及依赖包到一个轻量级 、可移植的容器中,然后发布到任何流行的 Linux 机器上,也可以实现虚拟化 ;

容器是完全使用沙箱机制 ,相互之间不会有任何接口,更重要的是容器性能开销极低;

Docker 从 17.03 版本之后分为 CE(Community Edition-社区版)和 EE(Enterprise Edition-企业版)。

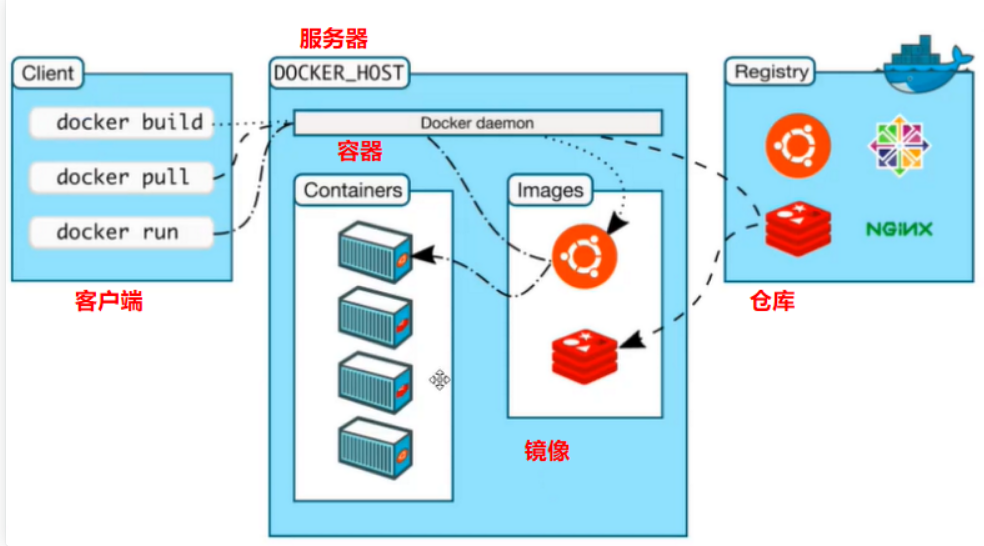

Docker是一个Client-Server结构 的系统,以守护进程运行在主机上。通过Socket 从客户端进行访问。

Docker 是 PaaS 提供商 dotCloud 开源的一个基于 LXC 的高级容器引擎,源代码托管在 Github 上

2、Docker应用场景

Web应用的自动化打包和发布,自动化测试和持续集成、发布;

在服务型环境中部署和调整数据库或其他的后台应用;

从头编译或者扩展现有的 OpenShift 或 Cloud Foundry 平台来搭建自己的 PaaS 环境。

3、Docker资源

4、Docker的优点

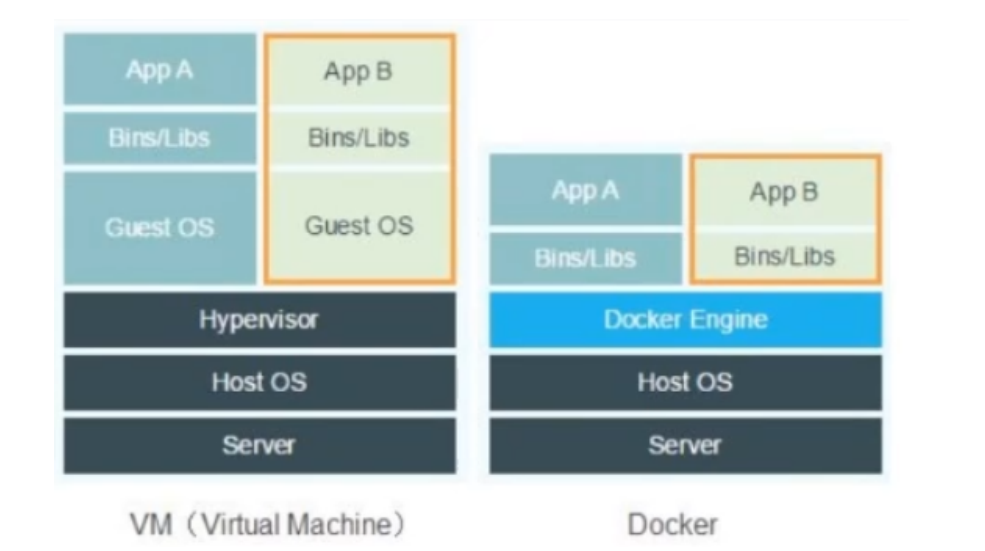

传统虚拟机与Docker对比:

虚拟机的缺点:

Docker的特点:

不模拟完整的操作系统,系统内核(kernel)非常小,更少的抽象层(GuestOS:如Centos)

容器内的应用直接运行在宿主机的内核,容器本身没有自己的内核 ,也没有虚拟硬件 。

每个容器相互隔离 ,内部都有属于自己的文件系统,互不影响。

5、Docker实现DevOps(开发、运维)

应用更快速的交付和部署

更便捷的升级和扩缩容?

更简单的系统运维

更高效的计算资源利用

6、Docker基本组成

镜像(image):镜像是一种轻量级、可执行的独立软件包,用来打包软件运行环境和基于运行环境开发的软件。它包含运行某个软件所需的所有内容,包括代码、运行时、库、环境变量和配置文件。相当于一个模板,通过这个模板来创建容器服务,可以通过一个镜像创建多个容器。

容器(container):独立运行一个或一组应用。基本命令有:启动,停止,删除等。可理解为一个简单的linux系统。

仓库(repository):存放镜像的地方(公有/私有)

7、Docker为什么比VM快

docker有着比虚拟机更少的抽象层。由于docker不需要Hypervisor实现硬件资源虚拟化,运行在docker容器上的程序直接使用的都是实际物理机的硬件资源。因此在CPU、内存利用率上docker将会在效率上有明显优势。

docker利用的是宿主机的内核,而不需要Guest OS。

GuestOS: VM(虚拟机)里的的系统(OS)

HostOS:物理机里的系统(OS)

因此,当新建一个 容器时,docker不需要和虚拟机一样重新加载一个操作系统内核。然而避免引导、加载操作系统内核是个比较费时费资源的过程,当新建一个虚拟机时,虚拟机软件需要加载GuestOS,返个新建过程是分钟级别的。而docker由于直接利用宿主机的操作系统,则省略了这个复杂的过程,因此新建一个docker容器只需要几秒钟。

二、Docker安装

1、安装

Docker官方安装文档:https://docs.docker.com/engine/install/

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 uname -r # 内核要求3.0以上# 1.卸载旧版本 # 2.需要的安装包 # 3.设置镜像的仓库 # 默认是从国外的,不推荐 # 推荐使用国内的 # 更新yum软件包索引 # 4.安装docker相关的 docker-ce 社区版 而ee是企业版 # 5、启动docker # 6. 使用docker version查看是否安装成功 # 7. 测试

2、卸载

1 2 3 4 5 # 1. 卸载依赖 # 2. 删除资源 # /var/lib/docker 是docker的默认工作路径!

3、镜像加速配置

参考:https://www.runoob.com/docker/docker-mirror-acceleration.html

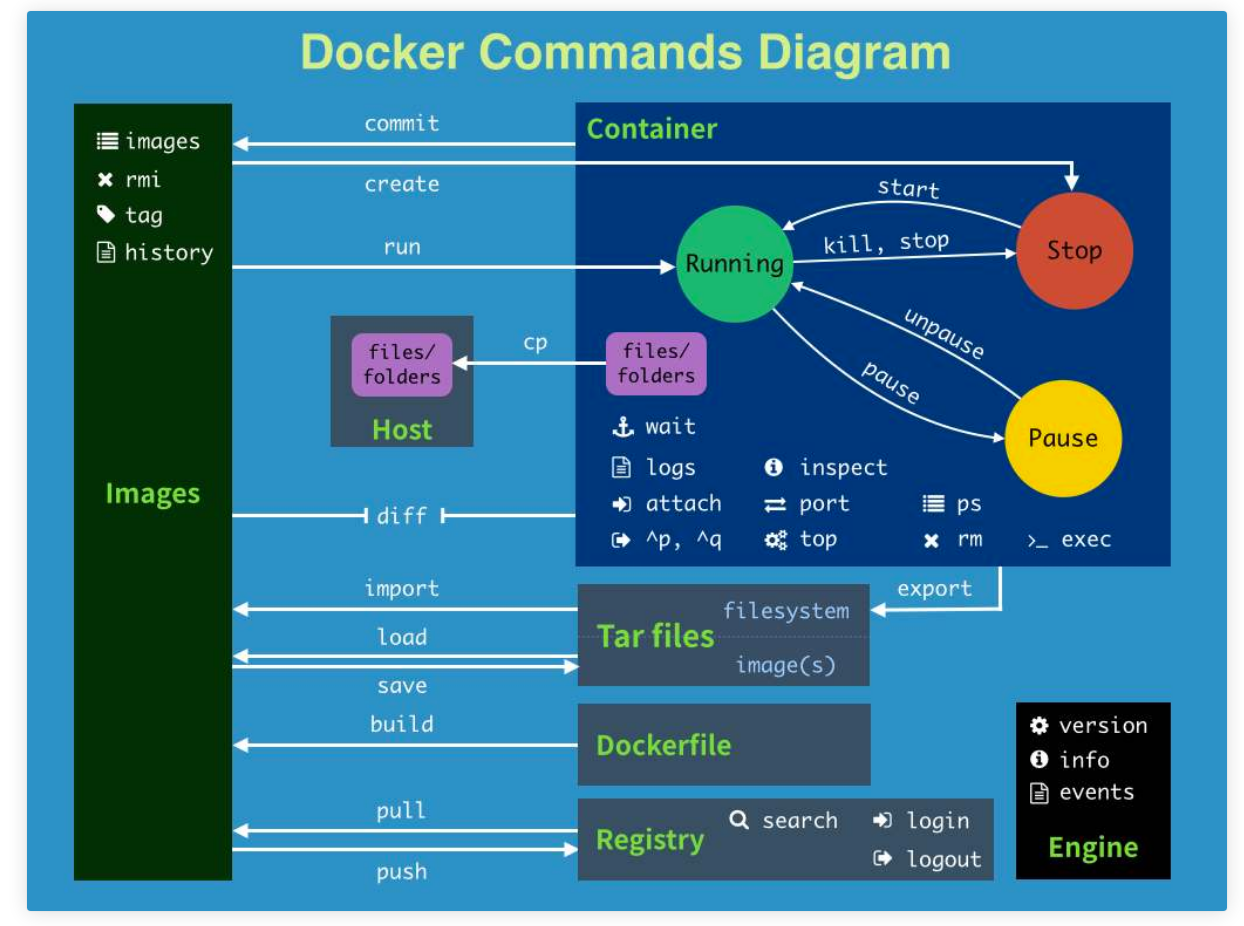

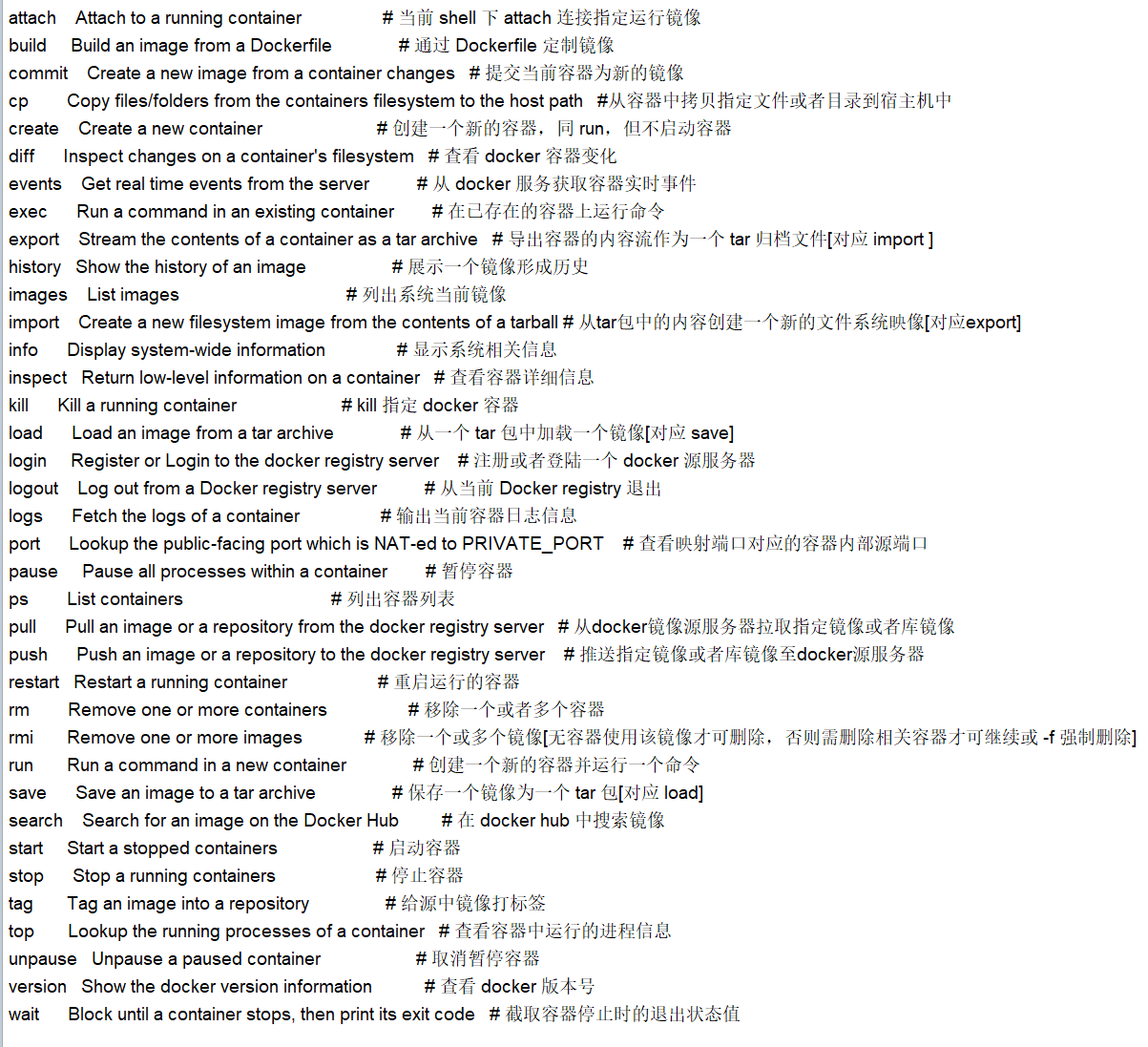

三、Docker命令

Docker命令的详细使用方法请参考 官网 或者 docker --help 进行查询,这里只记录部分常用命令。

pull

从镜像仓库中拉取或者更新指定镜像,在未声明镜像标签时,默认标签为latest。

1 2 3 4 Usage: docker pull [OPTIONS] NAME[:TAG|@DIGEST]

run

创建并启动一个容器

常见的坑,docker容器使用后台运行,就必须要有要一个前台进程,docker发现没有应用,就会自动停止!

容器运行的命令如果不是那些一直挂起的命令 (比如运行top,tail) ,就是会自动退出的。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 Usage: docker run [OPTIONS] IMAGE [COMMAND] [ARG...]

build

通过 Dockerfile 构建镜像

1 2 3 4 5 Usage: docker build [OPTIONS] PATH | URL | -

commit

通过容器创建一个新镜像,提交当前容器为新的镜像

1 2 3 4 Usage: docker commit [OPTIONS] CONTAINER [REPOSITORY[:TAG]]

cp

在容器和宿主机之间拷贝文件

1 2 3 4 5 Usage:

exec

向正在运行的容器下发命令

1 2 3 4 5 6 7 8 Usage: docker exec [OPTIONS] CONTAINER COMMAND [ARG...]

export

将容器导出为一个tar包

1 2 3 Usage: docker export [OPTIONS] CONTAINER

images

列出镜像

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 Usage: docker images [OPTIONS] [REPOSITORY[:TAG]]true or false , true 列出没有标签的,false 相反

import

通过导入tar包的方式创建镜像

1 2 3 Usage: docker import [OPTIONS] file|URL|- [REPOSITORY[:TAG]]

kill

杀死一个或多个容器

1 Usage: docker kill [OPTIONS] CONTAINER [CONTAINER...]

load

从tar包加载一个镜像

1 2 3 4 Usage: docker load [OPTIONS]

login

登录Docker镜像仓库

1 2 3 4 Usage: docker login [OPTIONS] [SERVER]

logout

退出Docker镜像仓库

1 Usage: docker logout [SERVER]

logs

显示容器日志

1 2 3 4 5 6 7 8 9 10 11 12 Usage: docker logs [OPTIONS] CONTAINER

ps

列出容器

1 2 3 4 5 6 7 8 9 10 11 12 Usage: docker ps [OPTIONS]

push

将容器推送到镜像仓库

1 Usage: docker push [OPTIONS] NAME[:TAG]

rename

给容器重命名

1 Usage: docker rename CONTAINER NEW_NAME

restart

重启一个或多个容器

1 Usage: docker restart [OPTIONS] CONTAINER [CONTAINER...]

rm

删除一个或多个容器

1 2 3 4 5 6 7 8 9 10 Usage: docker rm [OPTIONS] CONTAINER [CONTAINER...]

rmi

删除一个或多个镜像

1 2 3 4 5 6 7 Usage: docker rmi [OPTIONS] IMAGE [IMAGE...]

save

将一个或多个镜像保存为tar包

1 2 3 Usage: docker save [OPTIONS] IMAGE [IMAGE...]

search

查找镜像

1 2 3 4 Usage: docker search [OPTIONS] TERM

start

启动一个或多个容器

1 Usage: docker start [OPTIONS] CONTAINER [CONTAINER...]

stats

显示容器资源使用情况

1 2 3 Usage: docker stats [OPTIONS] [CONTAINER...]

stop

停止一个或多个容器

1 Usage: docker stop [OPTIONS] CONTAINER [CONTAINER...]

tag

给镜像设置新的tag

1 Usage: docker tag SOURCE_IMAGE[:TAG] TARGET_IMAGE[:TAG]

inspect

获取容器或镜像的元数据

1 2 3 4 5 6 7 8 9 10 11 12 Usage: docker inspect [OPTIONS] NAME|ID [NAME|ID...]"Id" :"55321bcae33d15da8280bcac1d2bc1141d213bcc8f8e792edfd832ff61ae5066" ,"Created" : "2020-05-15T05:22:05.515909071Z" ,"Path" : "/bin/sh" ,

其他命令

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 docker version #显示docker的版本信息。

命令总结

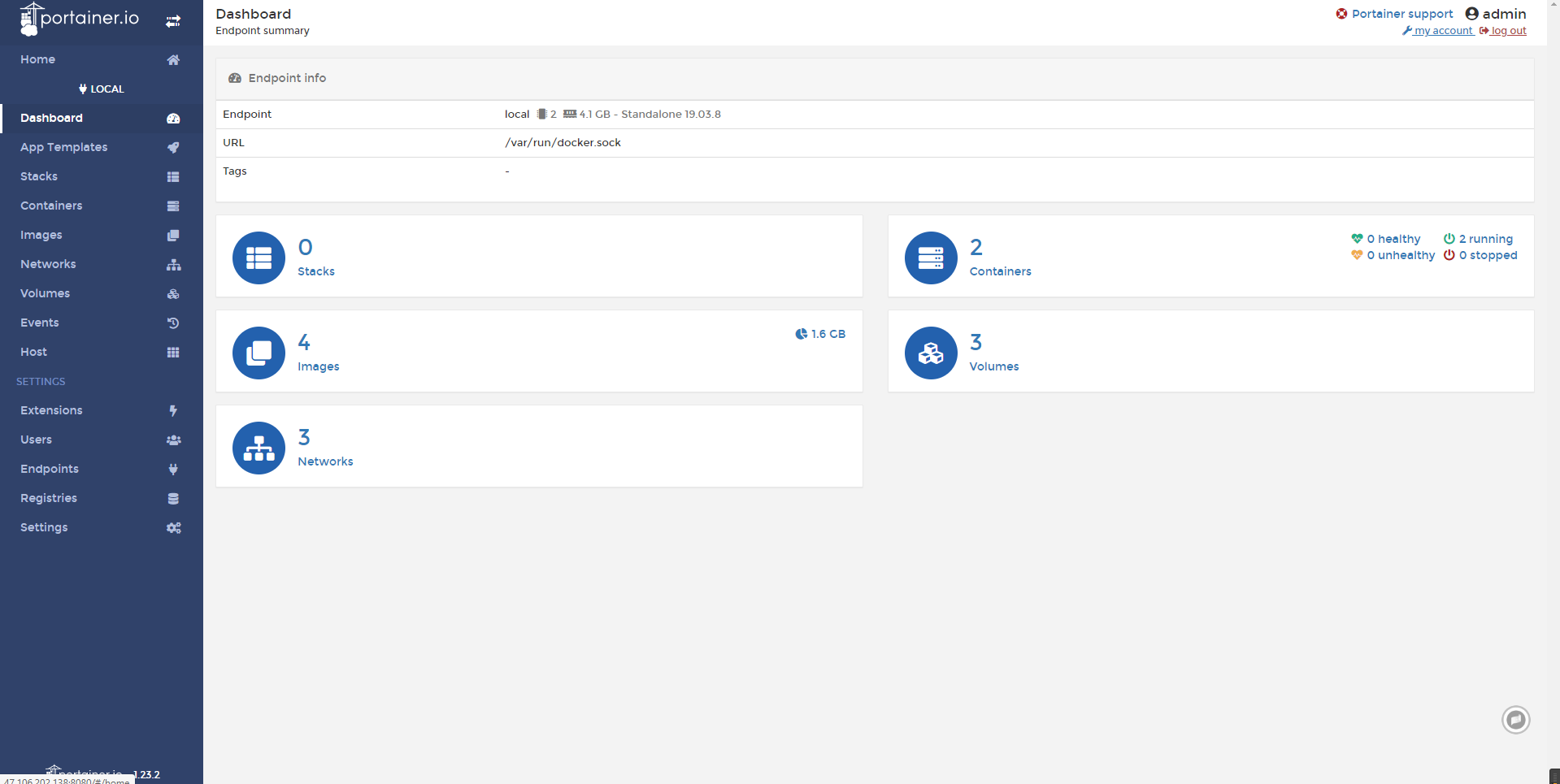

四、Docker可视化

Portainer:

Docker图形化界面管理工具!提供一个后台面板供我们操作!

1 2 docker run -d -p 8080:9000 \

**Rancher:**后面再用!

五、Docker镜像详解

1、UnionFS(联合文件系统)

联合文件系统(UnionFS)是一种分层、轻量级并且高性能的文件系统,它支持对文件系统的修改作为一次提交来一层层的叠加,同时可以将不同目录挂载到同一个虚拟文件系统下。联合文件系统是 Docker 镜像的基础。镜像可以通过分层来进行继承,基于基础镜像(没有父镜像),可以制作各种具体的应用镜像。

特性:一次同时加载多个文件系统,但从外面看起来只能看到一个文件系统。联合加载会把各层文件系统叠加起来,这样最终的文件系统会包含所有底层的文件和目录。

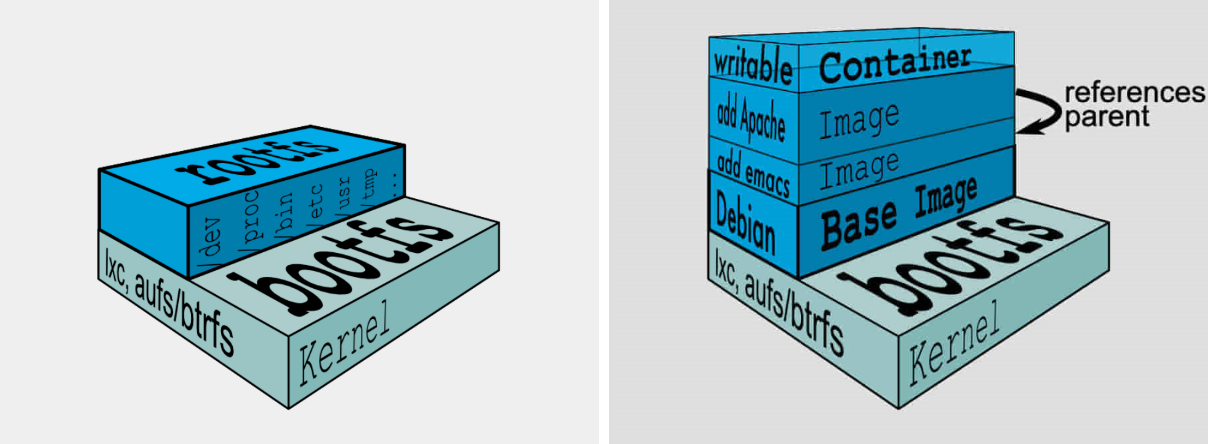

2、镜像加载原理

Docker的镜像实际由一层一层的文件系统组成:

bootfs(boot file system)主要包含bootloader和kernel。bootloader主要是引导加载kernel,完成后整个内核就都在内存中了。此时内存的使用权已由bootfs转交给内核,系统卸载bootfs。可以被不同的Linux发行版公用。

rootfs(root file system)包含典型Linux系统中的/dev,/proc,/bin,/etc等标准目录和文件。rootfs就是各种不同操作系统发行版(Ubuntu,Centos等)。因为底层直接用Host的kernel,rootfs只包含最基本的命令,工具和程序就可以了。

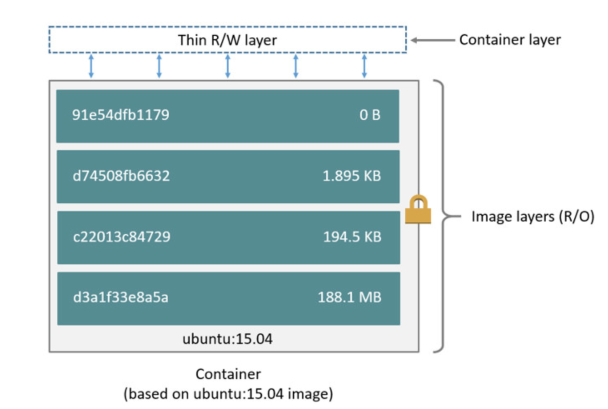

分层理解:所有的Docker镜像都起始于一个基础镜像层,当进行修改或增加新的内容时,就会在当前镜像层之上,创建新的容器层。容器在启动时会在镜像最外层上建立一层可读写的容器层(R/W),而镜像层是只读的(R/O)。

创建新的分层提交为新镜像:

1 docker commit -m="描述信息" -a="作者" 容器id 目标镜像名:[tag] # 编辑容器后提交容器成为一个新镜像

为什么Docker镜像要采用这种分层的结构呢?

最大的好处,我觉得莫过于资源共享 了!比如有多个镜像都从相同的Base镜像构建而来,那么宿主机只需在磁盘上保留一份base镜像,同时内存中也只需要加载一份base镜像,这样就可以为所有的容器服务了,而且镜像的每一层都可以被共享。

查看镜像分层的方式可以通过docker image inspect 镜像名命令:

1 2 3 4 5 6 7 8 9 10 11 "RootFS": {

Docker通过存储引擎(新版本采用快照机制)的方式来实现镜像层堆栈,并保证多镜像层对外展示为统一的文件系统。

Linux上可用的存储引撃 有AUFS、 Overlay2、 Device Mapper、Btrfs以及ZFS。顾名思义,每种存储引擎都基于 Linux中对应的件系统或者块设备技术,井且每种存储引擎都有其独有的性能特点。

Docker在 Windows上仅支持 windowsfilter 一种存储引擎,该引擎基于NTFS文件系统之上实现了分层和CoW [1]。

3、Commit镜像

如果你想要保存当前容器的状态,就可以通过commit来提交,获得一个镜像,就好比我们我们使用虚拟机的快照。

1 2 3 4 5 6 7 8 9 10 11 12 docker commit 提交容器成为一个新的副本# 命令和git原理类似 # 1、启动一个默认的tomcat # 2、发现这个默认的tomcat 是没有webapps应用,官方的镜像默认webapps下面是没有文件的! # 3、拷贝文件进去 # 4、将操作过的容器通过commit提交为一个镜像!我们以后就使用我们修改过的镜像即可,这就是我们自己的一个修改的镜像。

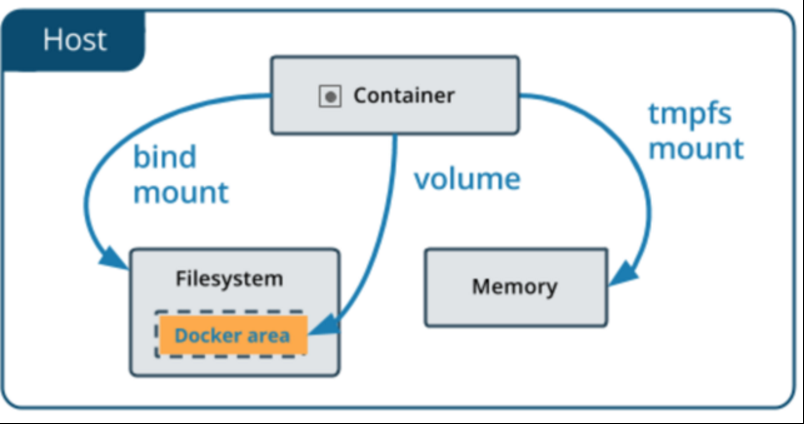

六、容器数据卷

1、什么是容器数据卷

为了实现数据持久化,使容器之间可以共享数据。可以将容器内的目录,挂载到宿主机上或其他容器内,实现同步和共享的操作。即使将容器删除,挂载到本地的数据卷也不会丢失。

卷 就是目录或文件,存在于一个或多个容器中,由docker 挂载到容器,但不属于联合文件系统,因此能够绕过Union FileSystem提供一些用于持续存储或共享数据的特性。卷的设计目的就是数据的持久化,完全独立于容器的生存周期,因此Docker不 会在容器删除时删除其挂载的数据卷

特点:

数据卷可在容器之间共享或重用数据

卷中的更改可以直接生效

数据卷中的更改不会包含在镜像的更新中

数据卷的生命周期一直持续到没有容器使用它为止

容器的持久化

容器间继承+共享数据

2、使用容器数据卷

挂载使用-v命令:

1 dokcer run -it -v 主机内目录:容器内目录 镜像名/id

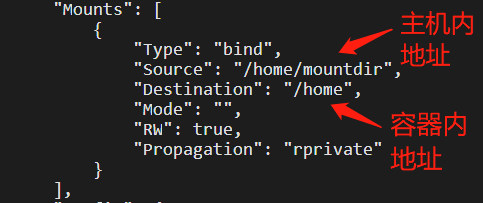

将容器内目录挂载到主机内目录上,通过docker inspect 命令查看该容器即可以看到挂载信息:

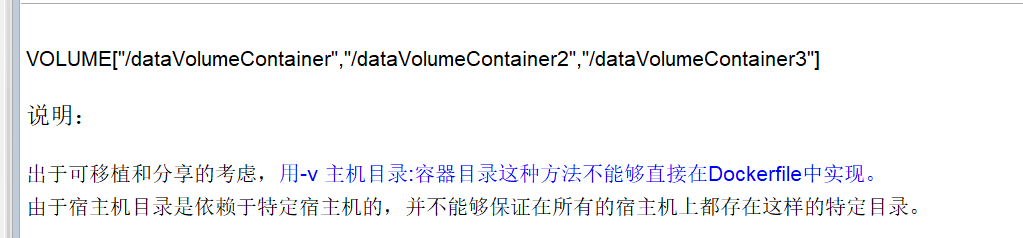

可在Dockerfile中使用VOLUME指令来给镜像添加一个或多个数据卷:

3、匿名挂载

命令:

1 docker run -d -v 容器内目录 镜像名/id # 匿名挂载

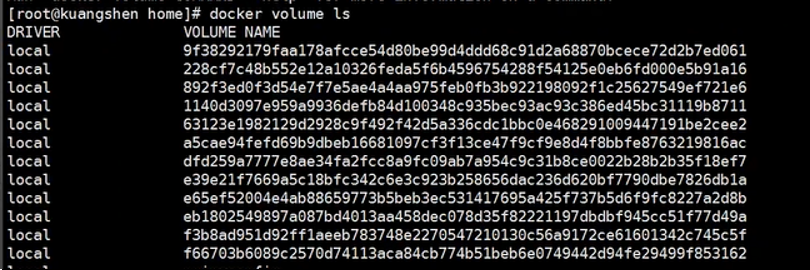

匿名挂载后,使用docker volume ls 命令查看所有挂载的卷:

每一个VOLUME NAME对应一个挂载的卷,由于挂载时未指定主机目录,因此无法直接找到目录,他有一个默认目录:在 /var/lib/docker/volumes/xxxx/_data下,xxx表示VOLUME NAME的字符串!

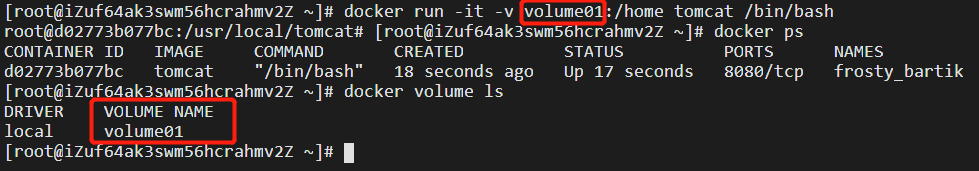

4、具名挂载

命令:

1 docker run -d -v 卷名:容器内目录 镜像名/id # 具名挂载

可以发现挂载的卷:volume01,并通过docker volume inspect 卷名 命令找到主机内目录:同样是在默认的/var/lib/docker/volumes/下:

所有docker容器内的卷,在未指定主机内目录时,都在:/var/lib/docker/volumes/卷名/_data 下,可通过具名挂载可以方便的找到卷,因此广泛使用这种方式进行挂载。

5、MySQL安装

1 2 3 4 5 # 获取mysql镜像 # 运行容器,需要做数据挂载,安装启动mysql,需要配置密码的,这是要注意点! # 参考官网hub

6、容器数据共享

--volumes-from:容器间共享挂载目录

1 2 3 4 docker run -d -p 3306:3306 -v /home/mysql/conf:/etc/mysql/conf.d -v /home/mysql/data:/var/lib/mysql -e MYSQL_ROOT_PASSWORD=123456 --name mysql01 mysql:5.7# 这个时候,可以实现两个容器数据同步!

7、小结

1 2 3 4 # 三种挂载: 匿名挂载、具名挂载、指定路径挂载

所有的docker容器内的卷,没有指定目录的情况下都是在 /var/lib/docker/volumes/xxxx/_data下

如果指定了目录,docker volume ls 是查看不到的。

容器之间的配置信息的传递,数据卷容器的生命周期一直持续到没有容器使用为止。但是一旦你持久化到了本地,这个时候,本地的数据是不会删除的!

拓展:

1 2 3 4 5 6 7 # 通过 -v 容器内路径: ro rw 改变读写权限 # ro 只要看到ro就说明这个路径只能通过宿主机来操作,容器内部是无法操作!

七、Dockerfile

Dockerfile是用来构建docker镜像的文件!

1、构建步骤

1、编写一个dockerfile文件,随后运行命令

1 2 3 docker build -f 文件路径 -t 标签 . # 文件名为Dockerfile时可省略-f

2、Dockerfile命令

命令

效果

FROM

基础镜像:Centos/Ubuntu

MAINTAINER

镜像作者+邮箱

RUN

镜像构建的时候需要运行的命令

ADD

为镜像添加内容(压缩包)(Copy + 解压缩 )

WORKDIR

镜像工作目录(进入容器时的目录)

VOLUME

挂载的目录

EXPOSE

映射端口配置

CMD/ENTRYPOINT

指定这个容器启动时要运行的命令(CMD替代先前命令,ENTRYPOINT在先前命令后追加)

COPY

类似于ADD,将文件拷贝到镜像中,COPY src desc 或 COPY[“src”, “desc”]

ENV

构建时设置环境变量

3、注意事项

每个保留关键字(指令)都必须是大写字母

从上到下顺序执行

“#” 表示注释

每一个指令都会创建提交一个新的镜像层并提交

2、CMD和ENTRYPOINT

区别测试:

CMD:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 # Dockerfile文件: # 构建镜像 $ docker build -f dockerfile-test-cmd -t cmd-test:0.1 . # 运行镜像 $ docker run cmd-test:0.1 # 想追加一个命令 -l 成为ls -al # cmd的情况下 -l 替换了CMD["ls" ,"-l" ]。 -l 不是命令所有报错 $ docker run cmd-test:0.1 -l

ENTRYPOINT:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 # Dockerfile文件 $ docker run entrypoint-test:0.1 # 我们的命令,是直接拼接在我们得ENTRYPOINT命令后面的 $ docker run entrypoint-test:0.1 -l

3、案例

独特的Centos:

vim mydockerfile-centos:

1 2 3 4 5 6 7 8 9 10 FROM centosMAINTAINER xxx<xxx@qq.com>ENV MYPATH /usr/localWORKDIR $MYPATH RUN yum -y install vim RUN yum -y install net-tools EXPOSE 80 CMD echo $MYPATH CMD echo "-----end----" CMD /bin/bash

1 docker build -f mydockerfile-centos -t mycentos:0.1 .

独特的Tomcat:

1 2 3 4 5 6 7 8 9 10 11 12 13 FROM centos MAINTAINER xxx<xxx@qq.com>COPY README /usr/local /README ADD jdk-8u231-linux-x64.tar.gz /usr/local / ADD apache-tomcat-9.0.35.tar.gz /usr/local / RUN yum -y install vim ENV MYPATH /usr/local WORKDIR $MYPATH ENV JAVA_HOME /usr/local/jdk1.8.0 _231 ENV CATALINA_HOME /usr/local/apache-tomcat-9.0 .35 ENV PATH $PATH:$JAVA_HOME/bin:$CATALINA_HOME/lib EXPOSE 8080 CMD /usr/local /apache-tomcat-9.0.35/bin/startup.sh && tail -F /usr/local /apachetomcat-9.0.35/logs/catalina.out

1 2 3 4 # 因为dockerfile命名使用默认命名 因此不用使用-f 指定文件 $ docker build -t mytomcat:0.1 . $ docker run -d -p 8080:8080 --name tomcat01 -v /home/www/build/tomcat/test :/usr/local /apache-tomcat-9.0.35/webapps/test -v /home/www/build/tomcat/logs/:/usr/local /apache-tomcat-9.0.35/logs mytomcat:0.1

4、发布镜像到DockerHub

1、使用docker login登录账号

1 2 3 4 5 6 7 8 9 10 11 [root@VM-8-2-centos ~]# docker login --help

2、使用docker push到远程仓库

1 2 3 4 5 6 7 # 会发现push不上去,因为如果没有前缀的话默认是push到 官方的library # 解决方法 # 第一种 build的时候添加你的dockerhub用户名,然后在push就可以放到自己的仓库了 $ docker build -t itnxd/mytomcat:0.1 . # 第二种 使用docker tag $ docker tag 容器id itnxd/mytomcat:1.0 $ docker push itnxd/mytomcat:1.0

八、Docker网络

1、Docker0

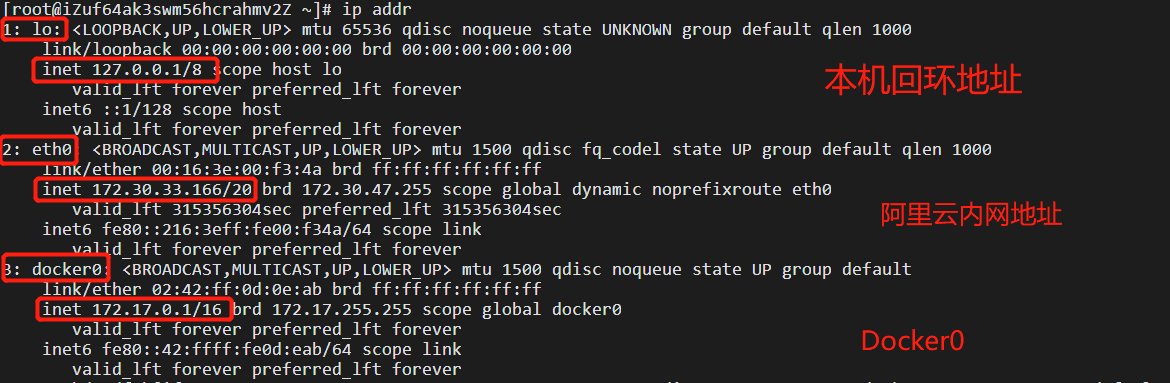

通过命令ip addr 查看本地ip地址,我们发现除了本机回环地址和的内网地址外,还多了一个网卡:Docker0,这是Docker服务启动后自动生成的。

而如果启动正在后台运行的tomcat容器,同样使用ip addr 命令,发现容器得到了一个新的网络:12: eth@if13 ,ip地址:172.17.0.2 。这是Docker在容器启动时为其分配的。

我们惊奇地发现了一个新网络13: vethda1df4b@if12 ,对应容器内网络地址的12: eth@if13 。

linux可以ping通docker容器内部,因为docker0的ip地址为172.17.0.1 ,容器为172.17.0.2 。在一个网段中!

原理:我们每启动一个docker容器,docker就会给容器分配一个默认的可用ip,我们只要安装了docker,就会有一个网卡docker0(bridge)。网卡采用桥接模式,并使用veth-pair技术(veth-pair就是一堆虚拟设备接口,成对出现,一段连着协议,一段彼此相连,充当一个桥梁。)。

docker中的所有网络接口都是虚拟的 ,转发效率高。删除容器后,对应的网桥也随之删除。

所有的容器不指定网络的情况下,都是docker0路由的,docker会给我们的容器分配一个默认的可用ip。

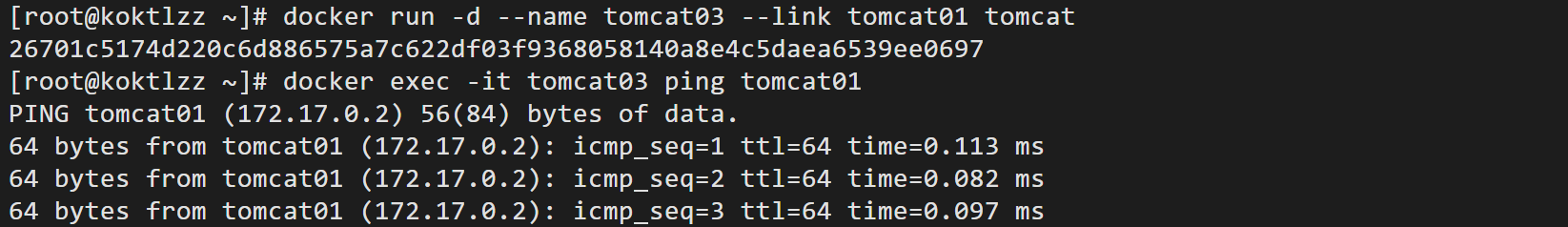

2、–link

若编写一个微服务并连接数据库,如果数据库ip改变,如何根据容器名而不是ip访问容器?显然,直接使用容器名是无法ping通容器内部的!

这时我们可以在容器启动命令中加入一个选项:–link ,使得我们可以根据容器名来访问容器。

1 docker run -d -P --link 容器名/id 镜像名/id

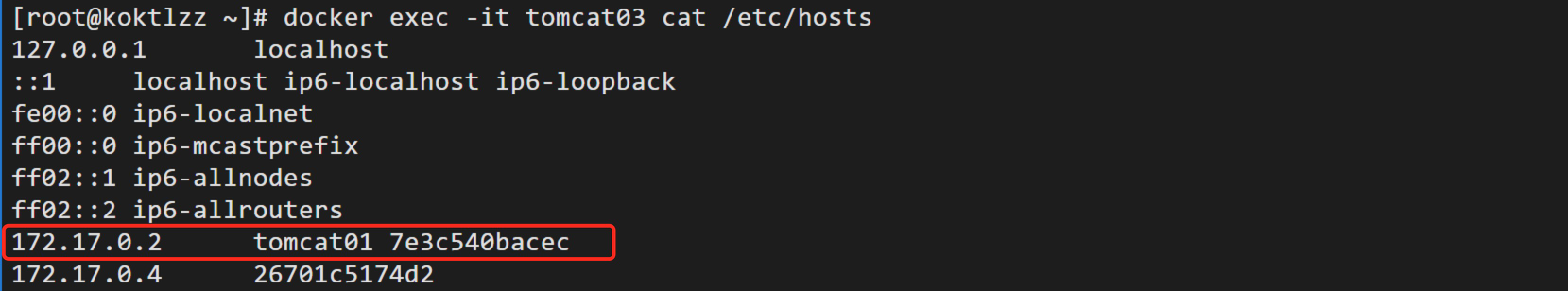

然而反向就不可以ping通,这是因为–link的本质是把需要连接的容器名/id写入启动容器的Hosts文件中,即增加了一个ip和容器名/id的映射:

目前已经不建议使用这种方式。

3、自定义网络

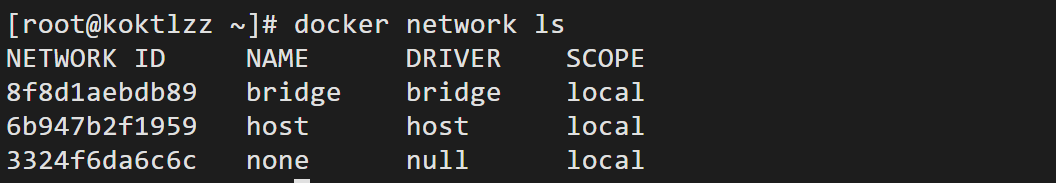

使用如下命令查看docker的网络类型:

1 docker network ls # 查看所有的docker网络

bridge:桥接(docker默认)

none:不配置网络

host:和宿主机共享网络

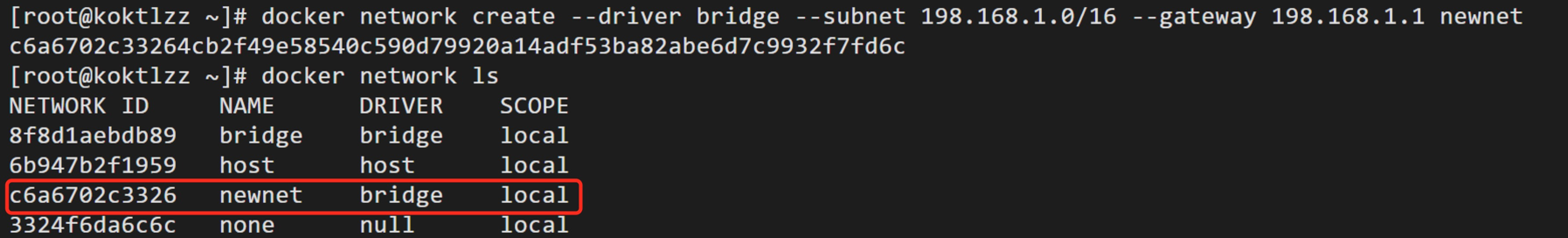

创建一个新的网络:

1 docker network create --driver 网络模式 --subnet 子网ip --gateway 网关 网络名

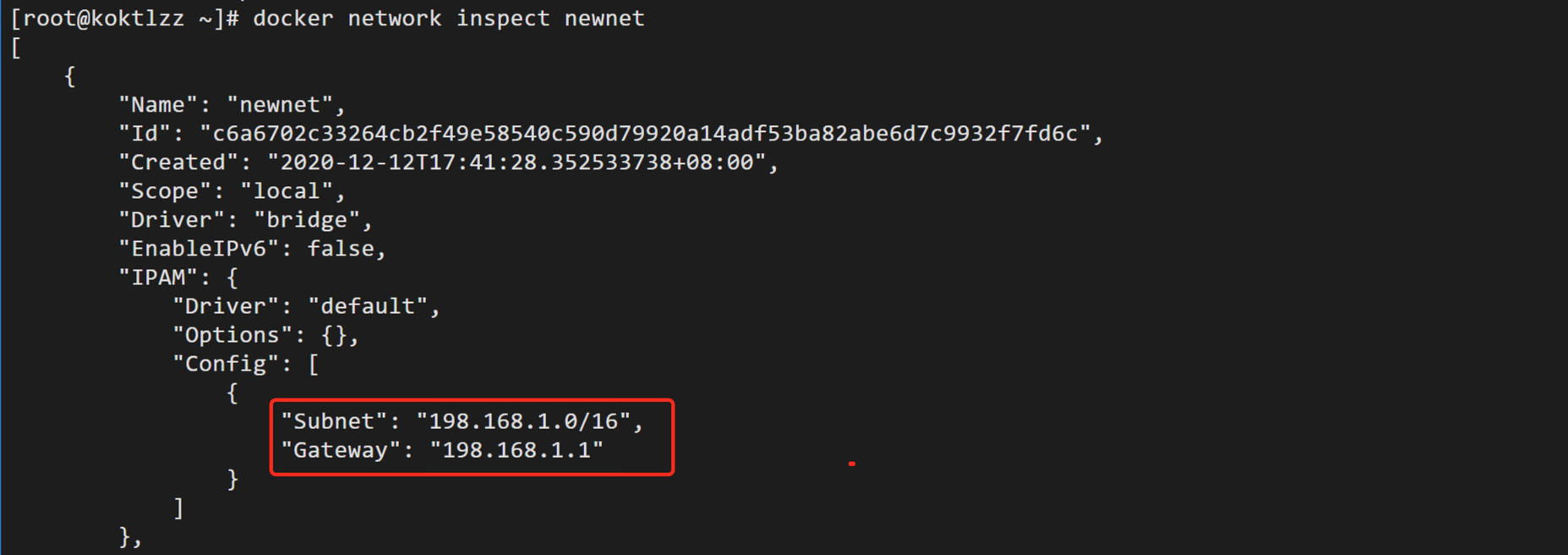

使用docker network inspect命令查看其详细信息:

只要多个容器启动时都通过 –net ,选用了同一个已创建的网络,不同容器间即可通过ip地址或容器名/id连通,因为都在一个网段内!

4、网络联通

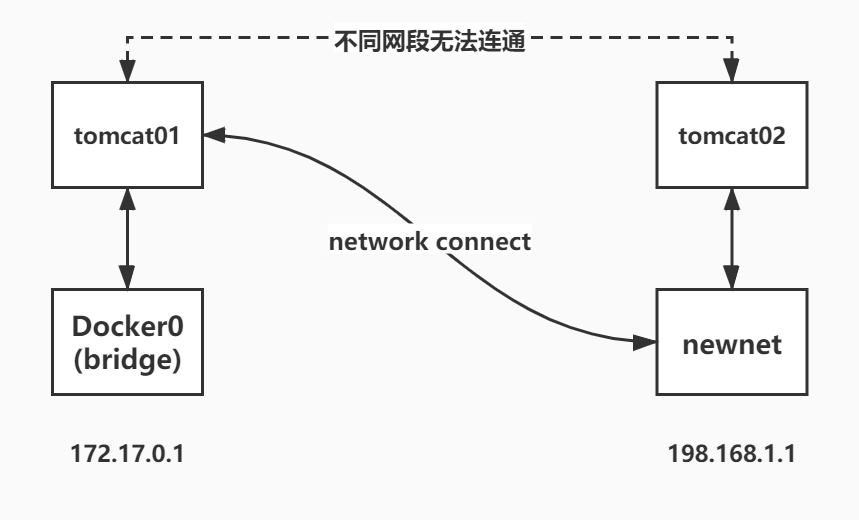

对于建立在不同网络下(docker0, newnet)的两个容器tomcat01和tomcat02,他们的网段不同,因此是无法彼此ping通容器内部的:

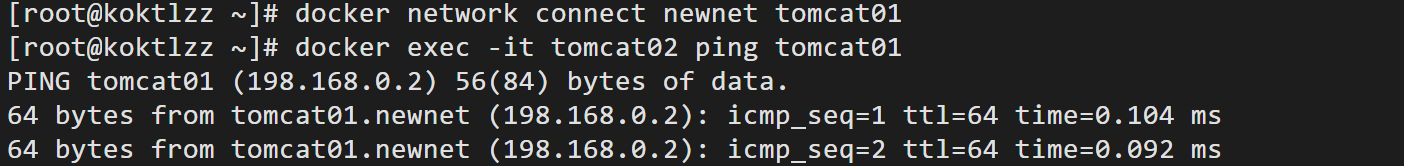

这时我们需要通过docker network connect 命令打通容器与网络之间的连接:

1 docker network connect 网络名 容器名/id

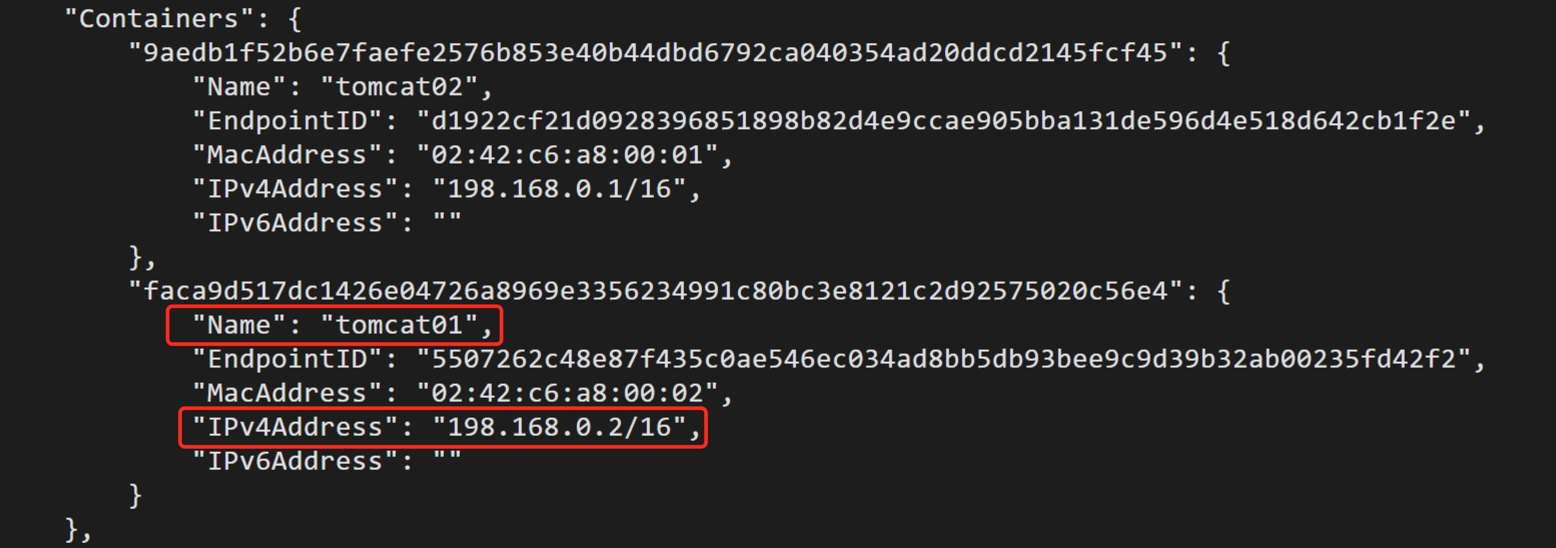

原理 :将一个容器赋予多个ip地址,同样可以用docker network inspect 命令查看网络连通后,该网络的变化:

新建的网络中绑定了一个新的容器!此时

九、Docker案例

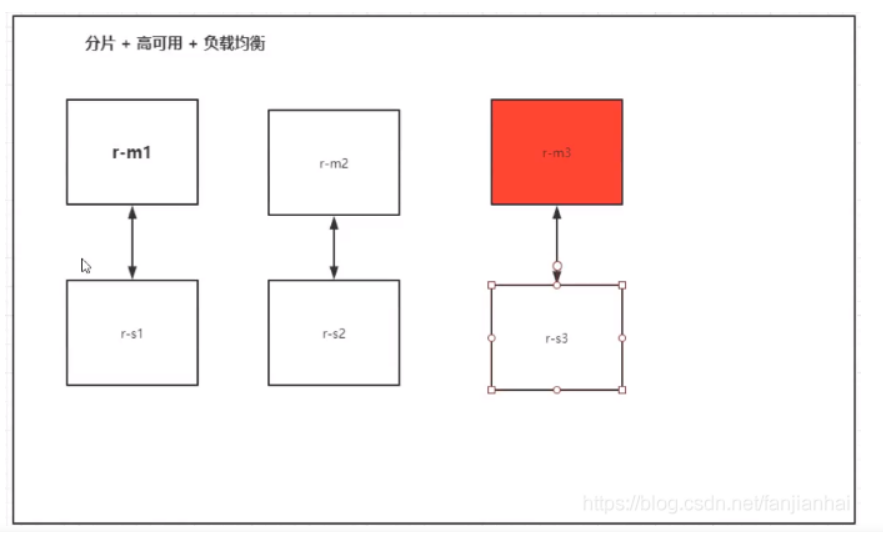

1、基于Docker的Redis集群搭建

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 # 创建网卡 # 通过脚本创建六个redis配置 # 创建结点1 # 创建结点2 # 创建结点3 # 创建结点4 # 创建结点5 # 创建结点6 # 创建集群 > >> Performing hash slots allocation on 6 nodes... > >> Nodes configuration updated > >> Assign a different config epoch to each node > >> Sending CLUSTER MEET messages to join the cluster > >> Performing Cluster Check (using node 172.38.0.11:6379) > >> Check for open slots... > >> Check slots coverage...

2、基于Docker的springboot项目部署

1、打包项目

2、编写Dockerfile

1 2 3 4 5 FROM java:8 COPY *.jar /app.jar CMD ["--server.port=8080" ] EXPOSE 8080 ENTRYPOINT ["java" , "-jar" , "/app.jar" ]

3、构建镜像

1 2 3 # 1.复制jar和DockerFIle到服务器 # 2.构建镜像 $ docker build -t xxxxx:xx .

4、发布运行

1 docker run -p 8080:8080 -t springboot/web-app-template 运行

十、Docker Compose

1、简介

Compose 是用于定义和运行多容器 Docker 应用程序的工具。通过 Compose,您可以使用 YML 文件来配置应用程序需要的所有服务。然后,使用一个命令,就可以从 YML 文件配置中创建并启动所有服务。

Compose 使用的三个步骤:

使用 Dockerfile 定义应用程序的环境。

使用 docker-compose.yml 定义构成应用程序的服务,这样它们可以在隔离环境中一起运行。

最后,执行 docker-compose up 命令来启动并运行整个应用程序。

2、安装

1 2 3 4 5 6 7 8 9 10 11 # 官网提供 (下载很慢) # 国内地址 # 授予可执行权限 # 测试是否安装成功

3、yaml

官方yaml样例及配置语法:https://docs.docker.com/compose/compose-file/compose-file-v3/#compose-file-structure-and-examples

菜鸟教程相关:https://www.runoob.com/docker/docker-compose.html

执行流程:

创建网络

执行Docker-compose.yaml

启动服务

4、部署自己项目

1、编写项目微服务

2、Dockerfile构建镜像

1 2 3 4 5 FROM java:8 COPY *.jar /app.jar CMD ["--server.port=8080" ] EXPOSE 8080 ENTRYPOINT ["java" , "-jar" , "/app.jar" ]

3、docker-compose.yml编排项目

1 2 3 4 5 6 7 8 9 10 11 12 version '3.8' services: xiaofanapp: build: . image: myapp depends_on: - redis ports: - "8080:8080" redis: image: "library/redis:alpine"

4、运行

1 2 3 4 docker-compose up # 运行

十一、Docker Swarm

需要购买多态服务器,或多台虚拟机!

推荐去阿里云或腾讯云购买按量付费的4台1h2g即可!

1、简介

Docker Swarm 是 Docker 的集群管理工具。它将 Docker 主机池转变为单个虚拟 Docker 主机。 Docker Swarm 提供了标准的 Docker API,所有任何已经与 Docker 守护程序通信的工具都可以使用 Swarm 轻松地扩展到多个主机。

支持的工具包括但不限于以下各项:

Dokku

Docker Compose

Docker Machine

Jenkins

2、Swarm集群搭建

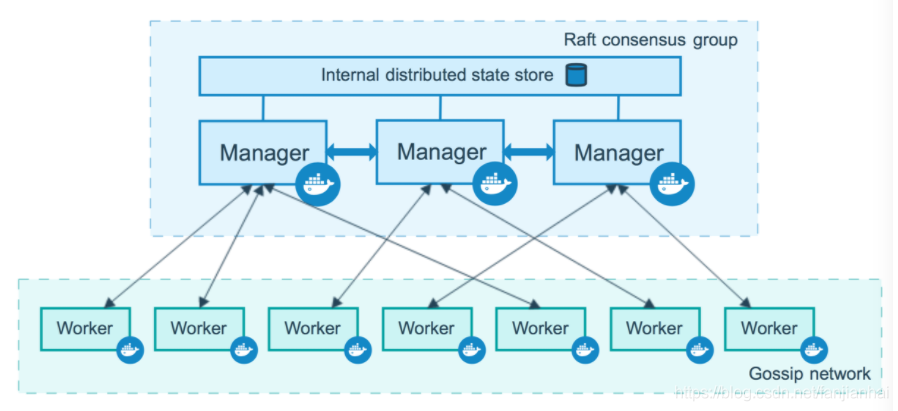

工作机制:

如下图所示,swarm 集群由管理节点(manager)和工作节点(work node)构成。

swarm mananger :负责整个集群的管理工作包括集群配置、服务管理等所有跟集群有关的工作。work node :主要负责运行相应的服务来执行任务(task)。

1 2 3 4 5 6 7 8 9 10 11 12 docker swarm init --help

docker swarm init:初始化结点

docker swarm join:加入一个结点!

docker swarm join-token manager:获取manger token令牌

docker swarm join-token worker:获取worker token令牌

docker node ls:查看节点信息

docker swarm leave:暂时离线,Status状态会改为Down

Manager Status:

Leader:表示是一个manager

Reachable:表示是另一个manager,且该服务正常

Unreachable:表示是另一个manager,但服务不正常

空:表示是一个worker

3、Raft协议

Raft协议:保证大多数 (指的是大于百分之五十即可)结点存活才可以使用,至少要有两台活着才能正常使用,集群至少要有3台manager!

例:双主双从时:将第一个Leader的docker停止后,就只有一个Reachable的主机无法判断是自己挂了还是别人挂了,即内部选举无法判断!大于三台才好判断!

4、docker service

操作集群,控制一个集群中的所有服务器就得使用docker service命令,可以用于动态扩缩容器!

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 docker run # 容器启动! 不具有扩缩容器# 整个集群创建nginx服务,不一定是哪台创建,动态的 # 创建副本 可以创建很多 内存足够即可 动态分配创建(不一定哪台会创建多少台) # 数字减小也会动态的将多的副本停掉! # 查看服务具体信息 # 停止某个节点接收新的任务 # 重新激活节点